Spesso, parlando di intelligenza, è utile non fare distinzioni fra esseri umani, animali o creature artificiali, come lo sono i robot o gli organismi simulati. Il termine agente è utile allo scopo e, in questo contesto, si riferisce a quelle proprietà che soggiacciono a tutti i sistemi che manifestano una qualche forma di intelligenza sulla cui definizione però, come si è visto, non c'è pieno accordo.

Ciò è dovuto al fatto che, sebbene si osservino empiricamente diversi livelli di intelligenza, non è possibile costruire una scala linearmente ordinata dei suoi valori per cui elementi come pensiero e capacità a risolvere problemi, apprendimento e memoria, linguaggio, intuizione e creatività, coscienza, emozioni, sopravvivenza in un mondo complesso, abilità sensomotorie, sembrano essere tutti attributi egualmante necessari per poter considerare intelligente un organismo.

Tuttavia l'intelligenza un comune denominatore sembra averlo; esso può riassumersi nella "capacità di adattamento che gli organismi mostrano quando si trovano in situazioni nuove e dalle quali vogliono ricavarne vantaggio". Questa caratteristica si manifesta come un'abilità a trovare il giusto compromesso fra diversità e adattamento (diversity-compliance trade-off), ossia, generazione delle differenze pur aderendo alla situazione corrente.

Quando si sottolineano le caratteristiche di intelligenza di un organismo spesso si impiega il termine agente, così diffuso nella letteratura scientifica da essere utilizzato per indicare, allo stesso tempo, sia una semplice procedura di calcolo sia una entità conscia e che, pertanto, ha perso gran parte del suo significato originale per il quale "un agente è un'entità distinguibile dal proprio ambiente in base a qualche tipo di delimitazione spaziale, temporale o funzionale e che possiede un certo grado di autonomia".

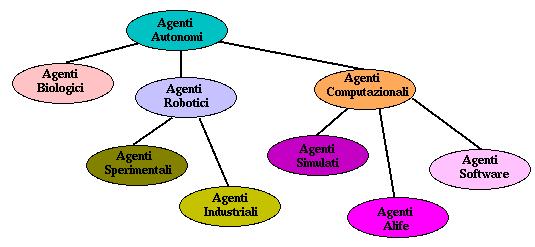

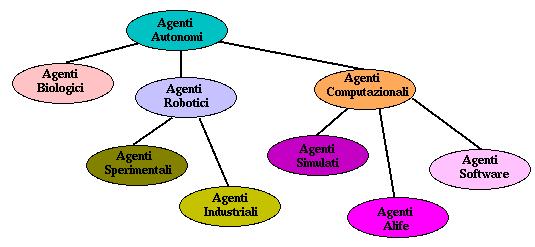

In altre parole, deve possedere qualche tipo di identità chiaramente identificabile nell'ambiente del quale fa parte e da cui deve differenziarsi. Per questa ragione il termine agente è molto generico e può riferirsi ad entità molte diverse fra loro: lo schema riportato di seguito ne mette in relazione alcuni di essi.

Per quanto riguarda la robotica la discussione sul significato di agente e sul suo impiego nella caratterizzazione dell'unità di governo del robot è riconducibile alle seguenti considerazioni.

Si è già visto che la realizzazione di robot autonomi può ottenersi partendo da diversi paradigmi dei quali quello gerarchico è maggiormente ispirato al punto di vista classico dell'Intelligenza Artificiale e che, per questo, si chiama anche knowledge-based.

Secondo il paradigma reattivo, invece, si segue un principio guida differente nel quale comprensione dell'ambiente entro cui il robot opera e definizione dei compiti che devono essere intrapresi, sono gli elementi base che ne caratterizzano la sua effettiva realizzazione.

L'applicazione diretta del paradigma gerarchico nel progetto di un robot autonomo che, d'ora in poi, chiameremo anche agente autonomo per mettere in evidenza un sistema di controllo la cui caratteristica essenziale è quella di interagire col mondo reale, mostra immediatamente che è impossibile costruire un robot che, dovendo svolgere un compito nel mondo reale, utilizza direttamente il punto di vista classico dell'Intelligenza Artificiale.

Per ovviare in parte a questo problema Brooks (1986) ha proposto di ottenere il comportamento intelligente non come funzione ma come proprietà emergente, impiegando un certo numero di processi paralleli debolmente accoppiati che funzionino in modo pressochè asincrono. Così facendo, l'elaborazione interna viene drasticamente ridotta potendo i segnali sensoriali essere mappati quasi direttamente sui comandi motori.

Ciascun processo corrisponde approssimativamente ad un comportamento, nel senso che si è detto nella lezione precedente, giustificando il termine behaviour-based dato a questo paradigma. L'architettura che ne risulta è caratterizzata da un forte accoppiamento sistema-ambiente e l'intelligenza non è più una "proprietà innata" del sistema ma, piuttosto, una proprietà che emerge in conseguenza dell'interazione del sistema col proprio ambiente, tanto più probabile quanto maggiori sono i processi paralleli che ne caratterizzano il suo controllo. In questo senso si richiede che l'agente sia dotato di un corpo con un proprio sistema sensoriale ed attuativo (embodied agent).

La realizzazione di agenti autonomi secondo il punto di vista dell'Intelligenza Artificiale classica è riconducibile al paradigma cognitivista, ispirato a The Computer and the Mind dello psicologo e linguista Phil Johnson-Laird (1988) nel cui saggio si afferma che i compiti principali della mente sono

Così facendo si lega indissolubilmente l'Intelligenza Artificiale alle Scienze Cognitive, termine che in letteratura è normalmente attribuito ad uno studio interdisciplinare dell'intelligenza, o della mente. Quando tale studio viene fatto in modo sintetico allora si parla di metodologia di comprensione per costruzione. Le Scienze Cognitive si riferiscono anche all'esplorazione dei principi generali dell'intelligenza sovrapponendosi esplicitamente all'intelligenza artificiale. La differenza fra le due è che la prima è più vicina a scienze empiriche come psicologia, etologia e biologia mentre la seconda è fortemente legata alla computer science, gli algoritmi e la logica.

Per verificare le caratteristiche di intelligenza di un agente è possibile utilizzare alcuni test, i più famosi dei quali sono: il Test di Turing e la Stanza Cinese di John Searle. Entrambi si basano su prove di tipo linguistico per cui non possono riguardare capacità che si esprimono su altri piani. Comunque sia, il test di Turing diventa interessante quando vengono poste sempre nuove domande in modo che non si possa sospettare che le risposte siano già state programmate.

L'Intelligenza Artificiale tradizionale e le scienze cognitive procedono sviluppando modelli computazionali delle funzioni mentali. L'intelligenza, intesa come capacità di pensare, è riconducibile ad una attività di elaborazione e compresa in termini di programmi che ricevono input, lo processano e forniscono output. Il cervello umano è paragonabile ad un grosso elaboratore che

Secondo questo punto di vista, chiamato la metafora dell'information processing, il cervello è la sede dell'intelligenza dove il ciclo input-processing-output degli elaboratori si trasforma nel ciclo sensing-thinking-act degli agenti intelligenti.

Riassumendo, i principi realizzativi degli agenti, secondo il punto di vista classico delle Scienze Cognitive sono:

Benchè lo schema realizzativo degli agenti, evidenziato nei punti precedenti, abbia riportato una serie di successi rilevanti in diversi campi applicativi, come lo sviluppo di Sistemi Esperti, resta il fatto che il punto di vista dell'Intelligenza Artificiale classica porta con se alcuni problemi importanti se applicato direttamente alla Robotica.

Nell'AI tradizionale e nelle scienze cognitive i modelli computazionali hanno un ruolo predominante. La metodologia sintetica, tuttavia, può essere estesa a comprendere non solo le simulazioni ma anche sistemi fisici, creature artificiali, che agiscono nel mondo reale. Questi sistemi si dicono agenti autonomi (indipendenti dal controllo umano). Tipicamente gli agenti autonomi hanno la forma di robot mobili e possono usarsi come modelli per sistemi biologici, umani e animali.

Gli agenti autonomi effettivamente agiscono nel mondo reale senza l'intervento dell'uomo. Sono dotati di sensori per percepire l'ambiente, ed eseguono azioni che possono modificare l'ambiente.